Mit Aussicht auf künstliche Wolken

Was wäre, wenn?

Stellen wir uns vor, es soll eine Panel Discussion oder eine Question-and-Answer-Runde durchgeführt werden. Die Teilnehmer sind allesamt Experten auf dem zu behandelnden Themengebiet, aber vielleicht auch ein wenig einseitig in ihren eingefahrenen Ansichten. Wäre es da nicht erfrischend, wenn einer der Teilnehmer eine Künstliche Intelligenz (KI) sein könnte? Also eine auf der Bühne per animiertem Avatar virtuell eingeblendete KI, mit denen die menschlichen Teilnehmer direkt per Sprache und in Echtzeit interagieren könnten und die im Hintergrund auf einer Generative AI aufsetzt und somit durch geballtes Wissen in die Runde vielleicht auch alternative Argumentationen einbringen könnte?

Wie realisiert man so etwas?

Genau dieses Szenario hatten im September 2024 Kollegen und Kolleginnen der msg aus dem Geschäftsbereich Public Sector und der Querschnittseinheit msg Artificial Intelligence für die Konferenz Nordl@nder Digital realisiert. Dazu wurden von ihnen geschickt drei Cloud-basierte AI-Services in der prototypischen Anwendung Dr. A.I. Futura kombiniert, welche auf einer bereits bestehenden Technik-Demo der auf künstliche Avatare spezialisierten Firma HeyGen basierte:

- Der produktive OpenAI Whisper AI-Cloud-Service wurde für die Realisierung der Speech-to-Text-Komponente verwendet, also der Übersetzung der Sprache (Audio) der menschlichen Konferenz-Teilnehmer in geschriebenen Text für ChatGPT.

- Der produktive OpenAI GPT AI-Cloud-Service wurde für die Realisierung der Text-to-Text- bzw. Chat-Komponente verwendet, also der Transformation der textuellen Fragen in textuelle Antworte, wie wir es von ChatGPT gewohnt sind.

- Der experimentelle HeyGen Interactive Avatar AI-Cloud-Service wurde schließlich für die Realisierung der anschließenden Text-to-Speech-Komponente verwendet, also der Übersetzung der textuellen Antworten von ChatGPT in natürliche Sprache (Audio) und der Visualisierung durch einen lippensynchronisierten Avatar (Video).

Wie kriegt man das in einen Event integriert?

Da diese Lösung fachlich so gut auf der Panel Discussion der öffentlichen Konferenz ankam, wollten wir dasselbe Feature natürlich auch gerne für unsere eigenen Events im msg Filmstudio zur Verfügung stellen können. Allerdings ist bei einer Studio-Produktion die nahtlose und stabile Integration einer solchen Software-Komponente der entscheidende Faktor. Da diese Integration mit dem bestehenden Prototypen leider nur bedingt gut funktionierte, haben wir Anfang Oktober 2024 eine ganz neue Anwendung namens Studio AI entwickelt, die auch als Open Source Software verfügbar ist.

Screenshot von Studio AI (links: Control-Mode in Google Chrome, rechts: Render-Mode in OBS Studio)

Wie der Name der Anwendung bereits vermuten lässt, ist hier der Fokus vor allem auf der nahtlosen Integration der AI in eine Studio-Umgebung. Dies bedeutet, dass vor allem auf der Input-Seite (Speech-to-Text) ein Operator flexibel eingreifen kann und auf der Output-Seite (Text-to-Speech) der resultierende Avatar sauber freigestellt abgegriffen und in die Produktion wieder eingespielt werden kann.

Gleichzeitig wurde in dieser Anwendung die zentrale Speech-to-Text-Komponente durch den exzellenten AI-Cloud-Service Deepgram realisiert, um eine noch niedrigere Latenz und hohe Qualität zu erreichen.

Jetzt kann man sogar mit bayerischem Dialekt sprechen: "Servus, sog amoi: wen mir in Minga von da Wiesn redn, wos moana mir da eigentlich?" (auf Hochdeutsch: "Hallo, sag Mal: wenn wir in München von der Wiese sprechen, was meinen wir da eigentlich?"). Und dann hat die nachgeschaltete Text-to-Text-Komponente auch eine echte Chance mit dem "Oktoberfest" zu antworten.

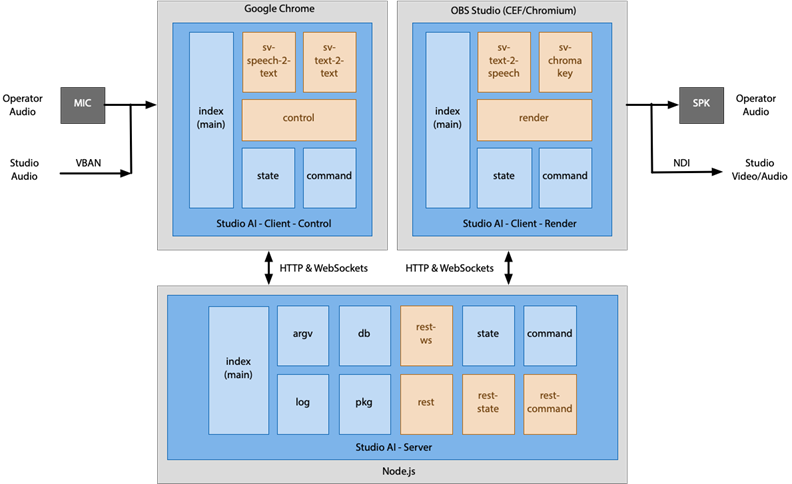

Das folgende Diagramm zeigt die Architektur von Studio AI: es ist eine Client/Server-Architektur, bei dem der Client zwei Mal gestartet wird und jeweils einen bestimmten Modus einnimmt. Im Control-Mode (siehe auch links im obigen Screenshot) kann der Operator über einen normalen Browser alle Parameter der drei AI-Cloud-Services detailliert einstellen und dann unter Laufzeit diese drei Services steuern. Im Render-Mode (siehe auch rechts im obigen Screenshot) wird der Avatar in einer Video-Mixing-Anwendung wie OBS Studio freigestellt dargestellt und dort für die weitere Verarbeitung abgegriffen.

Architektur (Functional View) von Studio AI

Wie mutet das Ergebnis an?

Schauen wir uns nun ein kleines Demo an, bei dem ich eine kurze, belanglose Unterhaltung mit einer durch Studio AI realisierten KI im msg Filmstudio führte. Bis auf die manchmal immer noch etwas hohe Latenz von etwa vier Sekunden fügt sich dieser KI-Avatar schon recht nahtlos in so eine Produktion ein, wie man in dem Video gut sehen kann. Links unten wird in diesem Demo übrigens der Control-Mode-Client des Operators in Echtzeit eingeblendet, so daß man sieht, wie der Avatar im Hintergrund gesteuert wird.

Der Operator hat hier übrigens die primäre Aufgabe der Speech-to-Text-Schnittstelle (im Screensharing links oben zu sehen) nur dann den Ton der Sprecher zukommen zu lassen, wenn die KI auch angesprochen wird. Ansonsten läuft in dieser Variante die Text-to-Text-Komponente (im Screensharing rechts zu sehen) und die nachfolgende Text-to-Speech-Komponente (im Screensharing links unten zu sehen) in ihrem jeweiligen Automatik-Mode.

Was können wir daraus lernen?

Mit der Realisierung des Prototypen und der Anwendung Studio AI haben wir verschiedene Erfahrungen gemacht:

- Orchestrierung: Es gibt manchmal nicht den einen AI-Service. Stattdessen muss man manchmal verschiedene Services miteinander auf API-Ebene integrieren und diese unter Laufzeit orchestrieren. In diesem Fall waren es sogar drei vollkommen verschiedene Services.

- Kreativität: Eine gewisse Integrations-Kreativität ist beim Umgang mit KI also in der Praxis fast immer gefragt. Außerdem muss man wissen, welche Services am Markt überhaupt existieren, wie gut sie jeweils sind und welche Integrationsmöglichkeiten man zur Verfügung hat.

- Cloud: Die meisten AI-Services kann man zwar mit viel Aufwand auch lokal laufen lassen (Stichwort: Ollama, etc), aber bestehende Services aus der Cloud zu nutzen ist deutlich produktiver und effizienter. Produktiver, da man viel schneller zur lauffähigen Lösung gelangen kann (Stichwort: time-to-market) und effizienter, weil lokale IT-Ressourcen manchmal den immer noch recht großen Ressourcenbedarf von Generative AI gar nicht stillen können — oder wenn sie ihn stillen können, man zumindest üblicherweise zu viel Ressourcen-Verschnitt bekommt, da man solche Lösungen meist über die gesamte Laufzeit nicht genügend in Summe auslasten kann.

- Aufwand: Die konkrete Anwendung Studio AI hat (auf industrielle Verhältnisse umgerechnet) etwa 250 Arbeitsstunden an Entwicklungsaufwand gekostet und besteht aus 4.600 Lines of Code (LoC). Diese Erfahrung zeigt, dass die Aufwände für so eine Art von AI-Cloud-Integrationslösung in der Praxis recht überschaubar sind. Allerdings sei angemerkt, daß die angegebenen Arbeitsstunden implizieren, daß man sich bereits sehr gut mit Web, Cloud, AI und Multimedia auskennen sollte.

- Datenschutz: Beim Einsatz von Cloud-Services muss man sich grundsätzlich um DSGVO- und Auftragsverarbeitungs-Aspekte kümmern. Da es sich hier um AI-Cloud-Services handelt, spielt der EU AI Act zusätzlich eine Rolle. Bei einer konkreten Produktion ist es also wichtig, dass nur bestimmte Sprachanteile in die KI fließen, dass die jeweils davon betroffenen Personen dafür auch vorab ihre explizite Einwilligung gegeben haben, dass nach der Verarbeitung keine personenbezogenen Daten irgendwie gespeichert zurückbleiben und in Summe keine vertraulichen Informationen über die Lösung kommuniziert werden.

- Gimmick: Zum Schluss sollte man gerne noch zugeben, dass eine solche KI durchaus auch nur als ein nettes, kleines Gimmick abgetan werden darf. Aber nicht alles im Leben muss staubtrocken und langweilig sein, damit es erst genommen werden darf. Wenn man für KI eine gewisse Begeisterung entstehen lassen will, dann sollte man nicht unterschätzen, wie wertvoll es sein kann, daß solche Lösungen auch Spaß machen können.

Fazit

Das Beispiel der Anwendung Studio AI zeigt, welche beindruckenden Möglichkeiten wir heute bereits mit Generative AI und Cloud Computing haben. Ich würde mir wünschen, daß auch traditionelle betriebliche Informationssysteme in Zukunft noch mehr von solchen AI-Cloud-Services profitieren. Vielleicht ebenfalls durch eine echte solche Sprachschnittstelle?